Новинні Telegram канали, засоби масової інформації та блогери, виробляючи тонни контенту, щоденно борються за увагу аудиторії. Не всі з них роблять це екологічно, вдаючись до такого явища як клікбейт. Що це таке, навіщо він використовується та чим шкодить — читайте в матеріалі “Бахмут IN.UA”.

Клікбейт — це…

Клікбейтні заголовки побудовані на психологічних прийомах: використання емоційних тригерів, цікавість, страх пропустити щось важливе та бути не в курсі. Його головне завдання — привернути увагу та змусити людей клікнути на покликання. І так — ця тактика працює. Настільки працює, що один з прикладів старезного клікбейту вже став мемом, розповсюдженим у російськомовному сегменті Інтернету: “щоб вилікувати цю хворобу, достатньо взяти звичайний радянський…”

Клікбейт у ЗМІ

Попри те, що Кодекс етики українського журналіста стверджує: “редакційна обробка матеріалів, включаючи знімки, текстівки, заголовки, відповідність відеоряду та текстового супроводу тощо, не повинна фальсифікувати зміст”, не всі засоби масової інформації дотримуються цього.

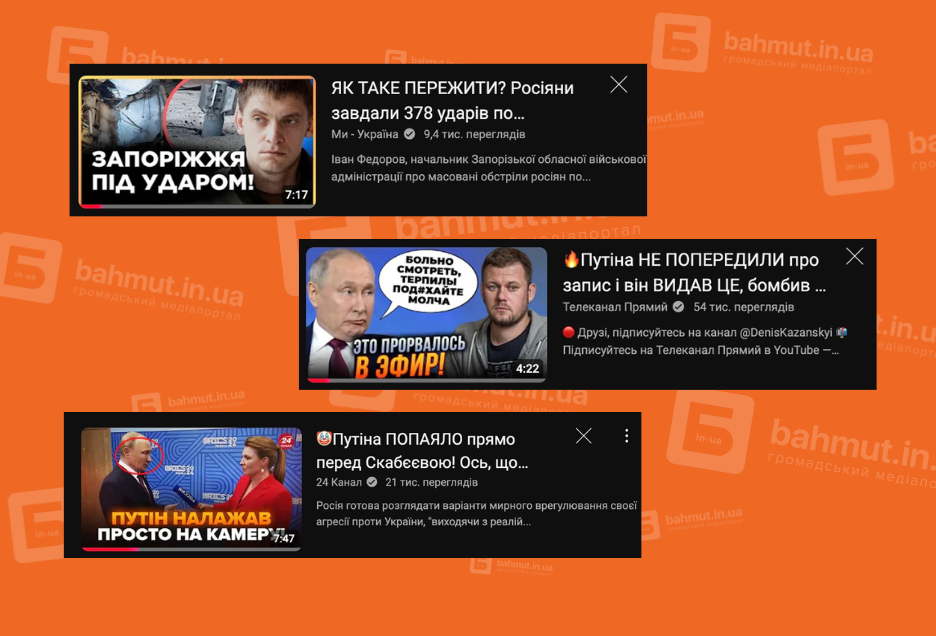

Яскрава клікбейтна обкладинка та гучна назва відео, частіше за все, ведуть до звичайних новинних сюжетів, які не містять у собі сенсаційної інформації. Таких прикладів у YouTube щоденно публікується сотнями, і всі вони скроєні за єдиним шаблоном.

Візьмемо до прикладу сюжет “24 каналу” від 26 жовтня 2024 року із кричущою назвою “😱СКАНДАЛ в ООН. Кислиця поставив Гутерреша НА МІСЦЕ! Жорстко РОЗНІС генсека цією ЗАЯВОЮ”. Які очікування можуть виникнути у потенційного глядача цього ролику? Як мінімум, відеодоказ того, що постпред України при ООН Сергій Кислиця кричить на генерального секретаря організації Гутерреша, і між ними дійсно виникає скандал. Що отримав глядач? Ведучу, що 10 хвилин у доволі монотонній манері пояснює як Сергій Кислиця у соцмережі Х (колишній Twitter) відреагував на візит Гутерреша до росії у рамках БРІКС. Тим часом відео отримало майже 300 тисяч переглядів.

Чим шкодить такий підхід медіа до висвітлення інформації? По-перше, він зменшує довіру до засобів масової інформації. Людина, не отримавши того, що її зачепило, розчаровується, запам’ятовує саму ідею того, що її “намахали” ЗМІ (не завжди запам’ятавши саме назву медіа) і втрачає довіру.

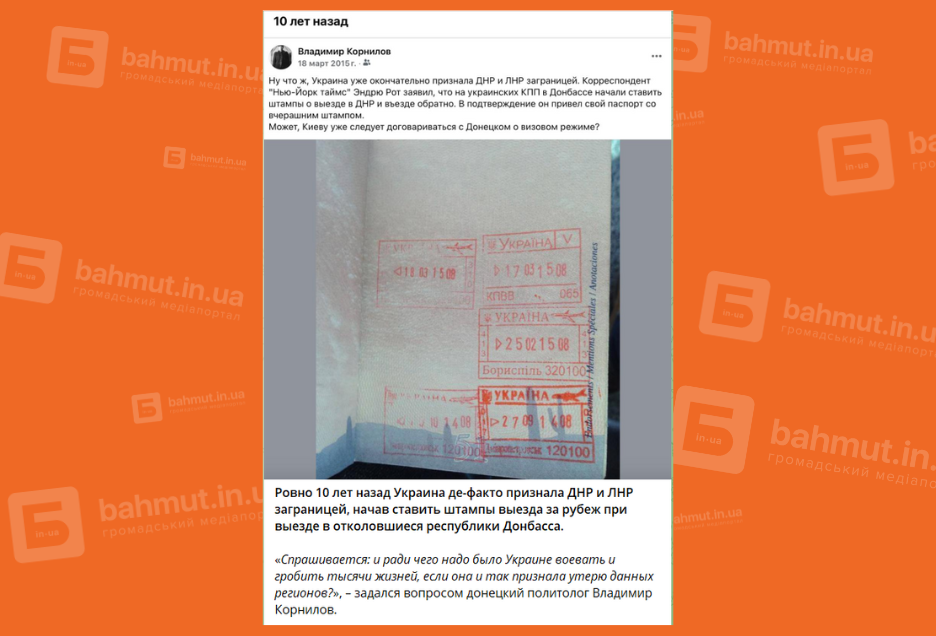

По-друге, подібні заголовки та обкладинки до відео — це дезінформація, і такий спосіб просування відеороликів заборонений Google. Глядачі не дивляться кожне відео з власних рекомендацій YouTube, але, гортаючи сторінку, візуально запам’ятовують інформацію. Думаємо, що кожна людина мала діалог на кшталт:

— Я бачив інформацію, що у росії скоро закінчаться гроші на війну?

— Ого, а кинь мені посилання.

— Ой, я не пам’ятаю де це бачив, десь писали.

Саме клікбейтні заголовки можуть бути причиною такого діалогу, а подібні дії деяких ЗМІ знижують рівень медіаграмотності населення.

Чому клікбейт — проблема

Якщо підсумувати, зловживання клікбейтними заголовками у довгостроковій перспективі може стати проблемою. Наведемо кілька причин, чому:

- розчарування і втрата часу. Люди нажимають на клікбейт, очікуючи отримати цікаву або важливу інформацію, але часто зміст не відповідає заголовку або є поверхневим. Це розчаровує і створює відчуття марно витраченого часу;

- поширення дезінформації. Деякі клікбейт заголовки перебільшують або навіть спотворюють факти, щоб привернути увагу. Це може вводити людей в оману, створювати неправильне враження про події або підкріплювати міфи й стереотипи;

- маніпуляція емоціями. Клікбейт активно експлуатує наші емоції, такі як страх щось пропустити, тривогу чи здивування. Це може викликати стрес або тривогу, особливо коли мова йде про теми, пов’язані з важливими темами (наприклад, війною, здоров’ям чи безпекою).

- зниження якості контенту. Коли сайти більше орієнтуються на кількість кліків, а не на якість інформації, страждає сам контент. Це призводить до того, що журналісти і автори надають перевагу поверхневим або сенсаційним матеріалам замість глибоких і добре досліджених статей;

- втрата довіри до медіа. Постійні клікбейти знижують довіру до сайтів і медіа, які їх використовують. Коли люди часто бачать клікбейт, вони починають сумніватися в об’єктивності та надійності таких ресурсів.

Через це клікбейт не просто дратує, але й негативно впливає на інформаційне середовище, ускладнюючи пошук правдивої та корисної інформації.

Як відрізнити клікбейт від корисного контенту

- занадто емоційний заголовок. Клікбейт часто використовує емоційно забарвлені слова, такі як “шокуюче”, “ви не повірите”, “сенсація” тощо. Якщо заголовок обіцяє щось неймовірне або намагається вас здивувати, це вже сигнал бути обережним;

- невизначеність і інтрига. Клікбейт заголовки часто навмисно розмиті або нечіткі. Наприклад, “Цей простий трюк змінить ваше життя!” або “Ось що сталося далі…”. Якщо немає конкретики, то це — типова ознака клікбейту;

- обіцянка “секретної інформації”. Якщо заголовок обіцяє “секретні факти” або “приховану правду”, це також майже на 100% “байт” на перегляди;

- розбіжність заголовка і змісту. Тут все наче просто: сама інформація не відповідає заголовку? Ви попалися на “замануху”.

Українська медійна громадська організація Інститут масової інформації у вересні 2024 року провела аналіз професійних стандартів онлайн-медіа. В моніторинговий період клікбейту було менше у ЗМІ, які аналізували представники ІМІ. Спеціалісти зазначили, що видання “Суспільне” “ефективно уникає клікбейту та емоційно забарвлених заголовків, демонструючи фокус на достовірності та відповідальності”.

Критичне мислення та обережність допоможуть вам уникати клікбейту та вибирати дійсно цінний контент. Окрім цього, радимо вам “білий” список медіа від Інституту масової інформації. До речі, наше медіа “Бахмут IN.UA” також є у списку регіональних якісних медіа. Журналісти цих майданчиків не роблять новини із гучними заголовками, які не відповідають дійсності. Тому радимо вам читати перевірені новини на сторінках цих ресурсів, які мають всі зручні способи комунікації з аудиторією.

Читайте також:

- Що не так із Telegram та чи має він альтернативи

- Цифрові медіаманіпуляції. Як обманюють за допомогою штучного інтелекту

- Ми всі із цим стикалися. Що таке “астротурфінг”

Бахмут живе тут – підписуйтесь на наш Телеграм та Інстаграм!